之前给大家分享了DeepSeek本地部署的内容,有友友提到了想要使用联网功能,毕竟能联网才能获取最新的知识,大模型的回答也将更加精准。 那我当然是无所谓,我会出手.jpg,经过一番折腾,搞定!

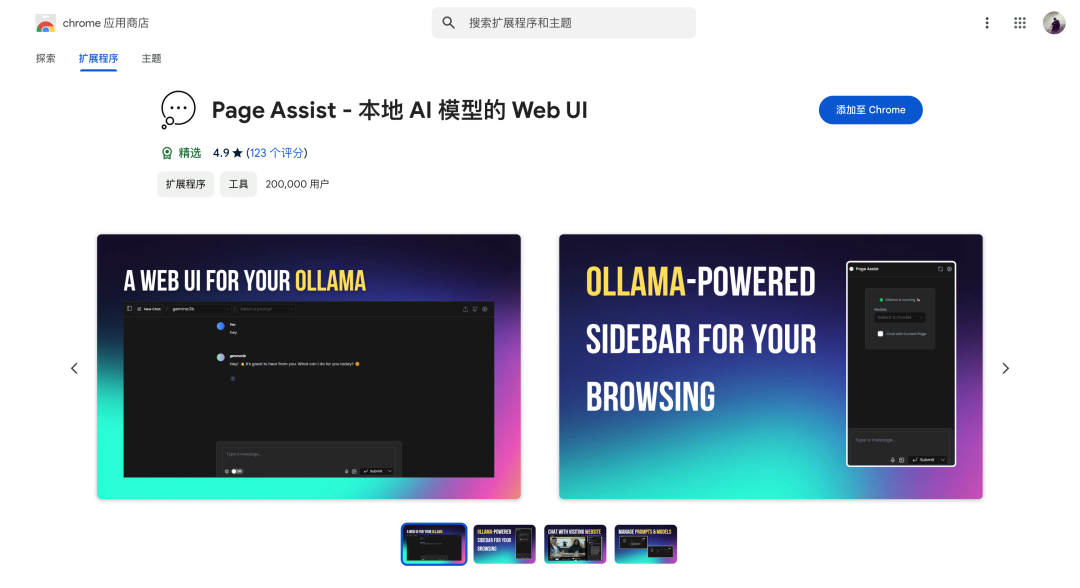

需要用到一个浏览器插件:Page Assist,它是一款开源浏览器扩展程序,可为你的本地AI模型提供侧边栏和可视化界面,允许你从任何网页与大模型模型进行互动。

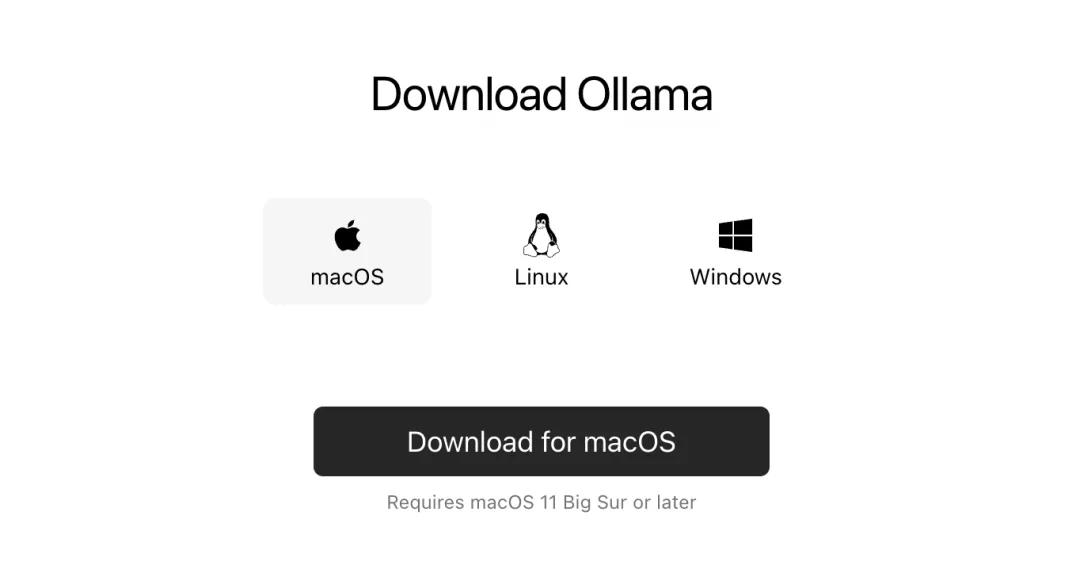

1、支持深度配合Ollama本地AI模型的Web UI(可视化界面),支持可视化交互操作 2、支持本地部署大模型的联网搜索功能 3、支持API大模型的接入和联网搜索功能 4、支持Chrome、火狐、Vivaldi等多种浏览器 第①步,安装Ollama和DeepSeek-R1本地大模型。 Ollama,它是一个轻量级、可扩展的大模型框架,就像是一位能够召唤各种大语言模型的魔法师。(文末附下载) 它不仅支持Windows、Linux、MacOS这些主流操作系统,还拥有一个庞大的模型库,包括Qwen、Llama等2000+大语言模型,最新的DeepSeek-R1当然也是支持的。

你只需轻轻一念咒语(输入命令),就能让这些模型为你所用,是不是很酷? 1、Windows安装 直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Windows(Preview)”。

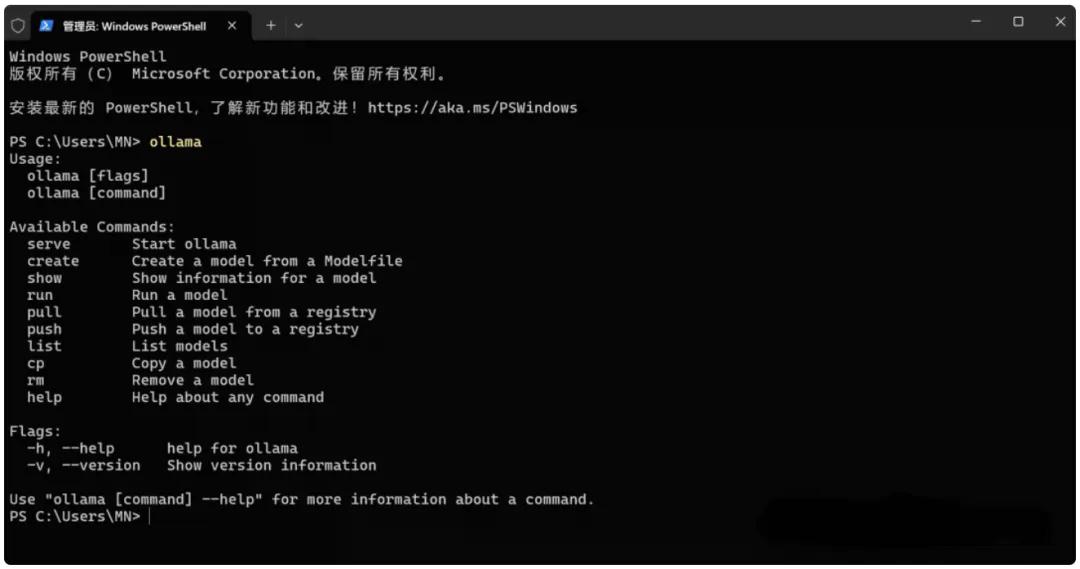

下载好以后,双击安装包,之后一直点击“install”安装即可。安装完成之后,打开一个cmd命令窗口,输入“ollama”命令,如果显示ollama相关的信息就证明安装已经成功了,如下图:

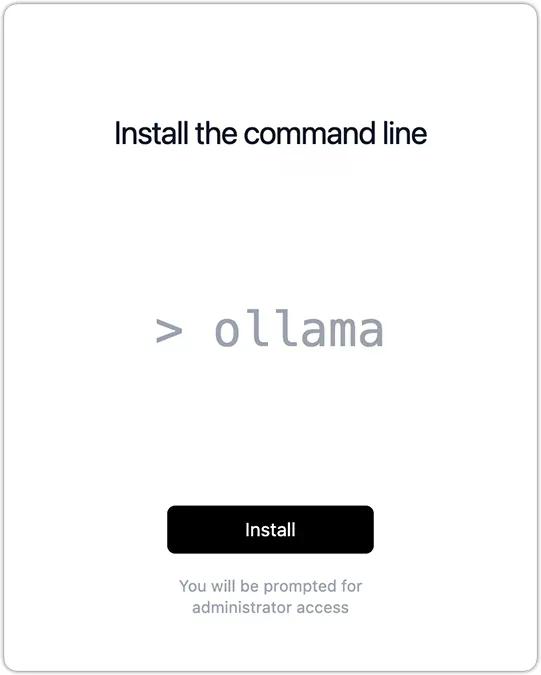

2、Mac安装 从下载页面,下载苹果系统相对应的安装程序,即点击“Download for Mac”。

下载好后,双击安装包,点击“install”,等待Ollama自动安装。

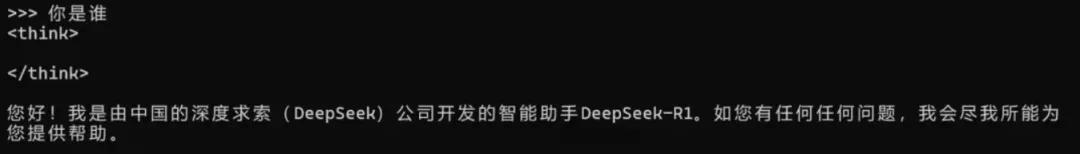

3、下载DeepSeek-R1模型 在安装完成后的Ollama中/或者你自行打开一个命令提示窗,输入以下指令,即可一键下载DeepSeek-R1大模型: 默认会下载的模型是7B参数Q4的量化版,6G小显存即可使用。如果需要下载其他尺寸的大模型,则修改相应参数:deepseek-r1:14b(代表下载14b的大模型)。 安装完成后,即可在提示窗中,直接向DeepSeek-R1提问了!

如果下次要使用DeepSeek-R1,只需重新打开一个命令提示窗,然后输入以下代码即可唤醒: 第②步,安装Page Assist插件。 这里我以Chrome浏览器为标准进行演示,火狐浏览器也是差不多的流程(无法科学上网的,可以选择火狐浏览器)。 1、打开谷歌应用商店:https://chromewebstore.google.com/,搜索“Page Assist – 本地 AI 模型的 Web UI”,然后点击“添加到 Chrome”即可。(文末提供插件的本地包+安装教程)

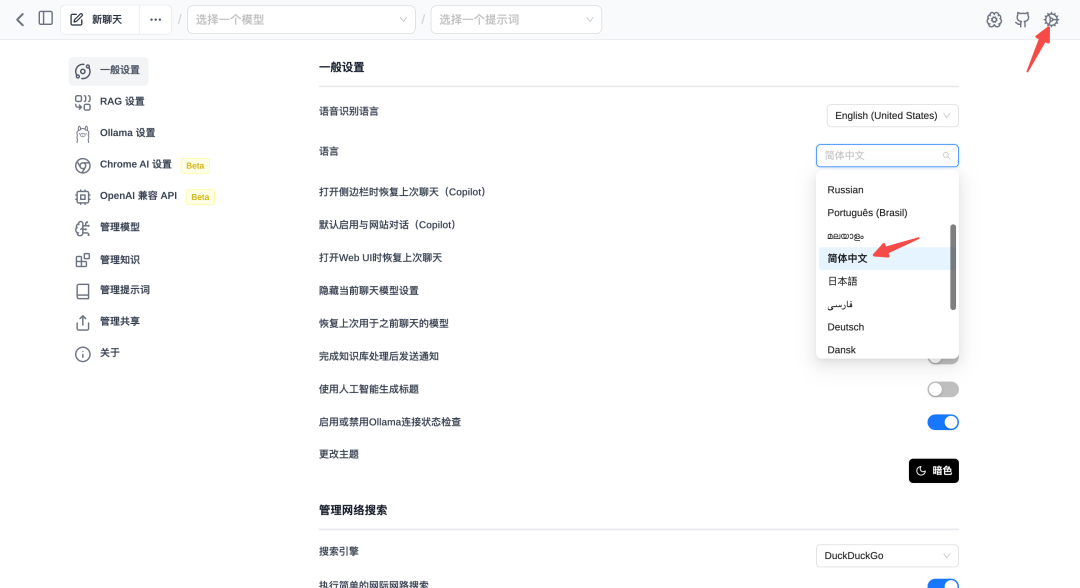

2、设置中文:点击Page Assist图标,然后点击右上角的“设置”按钮,在“一般设置”中,将“语言”更换成“简体中文”。

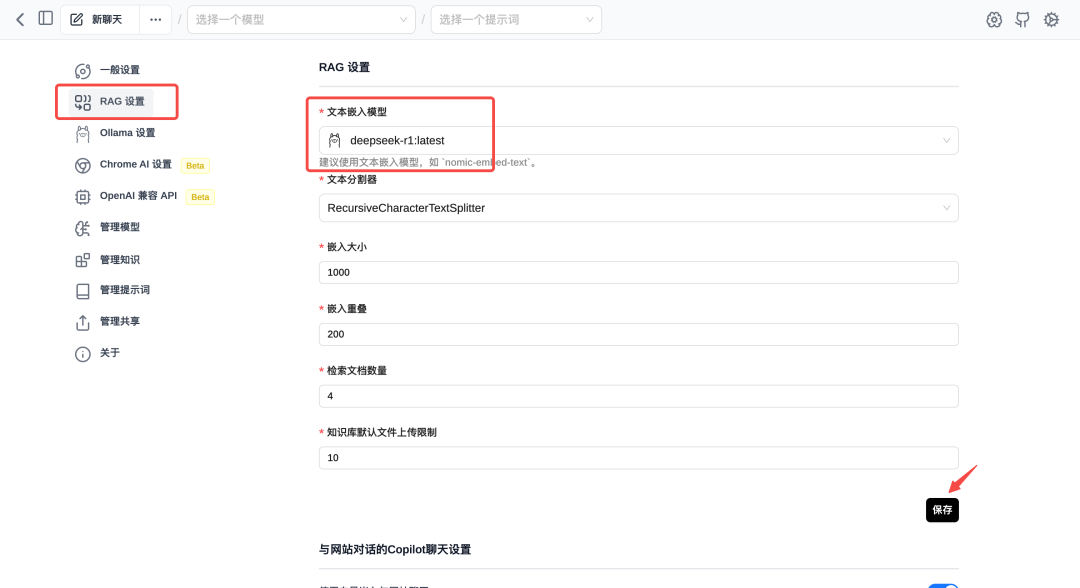

3、点击「RAG配置」,在文本嵌入模型中选取「deepseek-r1」模型,再点击保存即可。

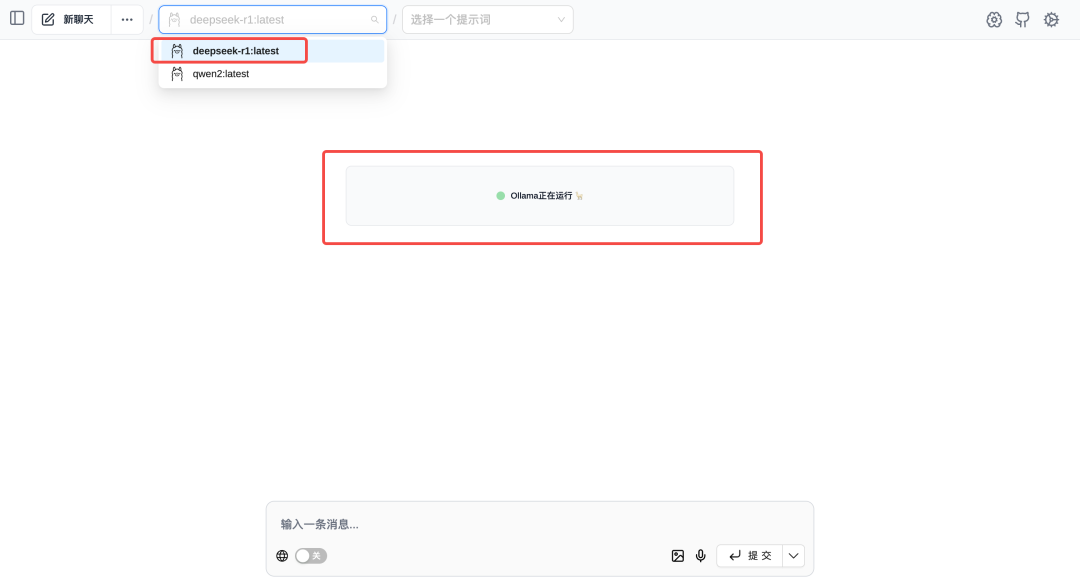

4、回到Page Assist主界面(注意需要启动Ollama),在页面中部看到文案“Ollama正在运行”即说明一切正常,然后再左上角选择「deepseek-r1」模型,然后在聊天界面打开“联网”开关,即可使用联网搜索聊天了。

以下是我亲测的效果:联网搜索电影《哪吒2》的最新信息,直接获取到了猫眼上哪吒2的最新票房,简直强大!

资源链接:https://pan.quark.cn/s/09da8e611613